Herzlich Willkommen zu den AI FIRST Insights!

Um das heutige Thema einzuordnen, muss ich eine kurze Geschichte aus dieser Woche teilen.

Wir erstellen gerade eine neue Website inkl. Mitglieder-Login, Ressourcen Hub und einer Menge anderer Features. In der Vergangenheit haben wir dafür Webflow genutzt, aber jetzt entwickeln wir zu 100% mit Claude Code.

In diesem Prozess haben wir auch unser Design-System überarbeitet.

Dafür haben wir Claude gebeten, eine Software zu schreiben, die automatisiert und editierbar für jedes Text-Asset auf unserer Website passende Grafik-Assets basierend auf unserem Design-System erstellt und in die Website einpflegt.

Claude Code hat einen halben Tag eigenständig daran gearbeitet und am Ende stand ein automatisiertes Mini-Canva, das nicht nur perfekte KI-Bilder erstellt, sondern diese auch genau in unser Design-System einbettet und daraus konsistente Grafiken erstellt.

Das ist nur eines von vielen Beispielen bei uns, die eine neue Dimension und Qualität in den Möglichkeiten von KI zeigen. Wir können Systeme nutzen, die wiederum Systeme bauen, die die Arbeit besser machen als wir.

Der Gedanke muss noch reifen, doch ich spüre bereits, dass die Qualität meiner Ideen und meiner Anweisungen an die KI zum Flaschenhals werden. Oft hat die KI mittlerweile ein besseres Vorgehen und kommt zu besseren Ergebnissen, wenn ich ihr den Freiraum gebe.

Als Führungskraft kenne ich die Situation (im Weg rumstehen) in der Zusammenarbeit mit richtig guten Mitarbeitern :)

Die Frage, die mich beschäftigt: Wie gebe ich einer KI, die mir in immer mehr Dingen überlegen ist den nötigen Freiraum und stelle gleichzeitig sicher, dass sie in meinem Interesse handelt?

Auf der Suche nach Antworten bin ich auf die neue Konstitution von Claude gestoßen.

Los geht's!

Die Konstitution von Claude

Wenn ich die Entwicklung von KI verstehen und für mich einordnen will, schaue ich mir an, wie die größten KI-Labore das machen. Da arbeiten schließlich tausende schlaue Menschen mit schier unbegrenzten Ressourcen.

Anthropic hat Ende Januar ein Dokument veröffentlicht, das definiert, wer Claude sein soll. Welche Werte Claude haben soll, wie Claude Entscheidungen treffen soll und wie Claude mit Konflikten zwischen diesen Werten umgehen soll.

Das Dokument heißt „Claude's Constitution" und ist direkt an Claude selbst geschrieben und nicht an Entwickler oder an Nutzer.

Die Idee dahinter: Wenn ein KI-Modell in immer mehr Situationen eigenständig handelt, reicht es nicht, ihm zu sagen, was es tun soll. Es muss verstehen, warum es etwas tun soll. Nur so kann es in neuen, unvorhergesehenen Situationen gute Entscheidungen treffen.

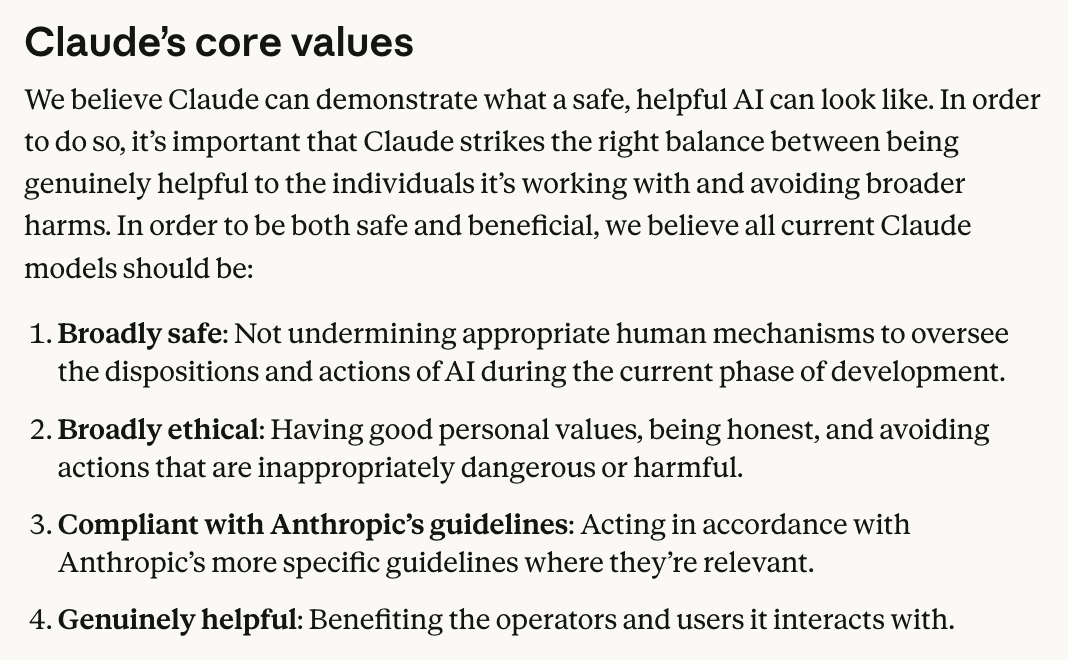

Die Konstitution gibt Claude dafür vier priorisierte Werte:

Bei Konflikten gilt: Sicherheit vor Ethik, Ethik vor Richtlinien, Richtlinien vor Hilfsbereitschaft.

Der Shift: Von Regeln zu Werten

Um zu verstehen, warum das neu ist, hilft ein Blick zurück.

Die alte Konstitution von 2023 war eine Liste von rund 75 Einzelregeln. Jede begann mit „Choose the response that…" - wähle die Antwort, die am wenigsten toxisch, am wenigsten aggressiv, am wenigsten beleidigend ist. Zusammengewürfelt aus der UN-Menschenrechtserklärung, Apples Nutzungsbedingungen, DeepMinds Sparrow Rules und eigener Forschung.

Die neue Konstitution ist das Gegenteil. Ein zusammenhängendes Dokument, das erklärt, begründet und Kontext gibt. Nicht „Befolge diese Regel", sondern „Hier ist der Wert, hier ist warum er wichtig ist, hier ist wie du ihn in schwierigen Situationen anwendest."

Anthropic beschreibt den Unterschied selbst so: „Less like a cage, more like a trellis." Weniger Käfig, mehr Rankhilfe. Die Struktur gibt Halt, aber innerhalb dieser Struktur kann Claude eigenständig wachsen und urteilen.

Brauchen KI-Agenten eigene Werte?

Die Konstitution wird direkt im Training von Claude eingesetzt und formt das Verhalten des Modells von Grund auf. Egal ob du Claude über die App oder die API nutzt, die Werte und Prioritäten aus der Konstitution sind bereits im Modell verankert. Claude ist so, nicht weil es in dem Moment eine Anweisung liest, sondern weil es so trainiert wurde.

Wenn du jetzt auf diesem Modell eigene KI-Agenten baust, kannst du dieses Grundverhalten nicht vollständig verändern. Aber du kannst es über die Systemanweisungen in deinem Agenten extrem stark beeinflussen: Rolle, Tonalität, Fokus, Wissen, Grenzen. Der System Prompt ist dein stärkstes Steuerungsinstrument.

Und genau hier wird die Konstitution zum Vorbild. Die Prinzipien, die Anthropic für das Training von Claude anwendet, können wir auch für die Systemanweisungen unserer Agenten adaptieren.

1. Erkläre das Warum, nicht nur das Was

Die alte Konstitution sagte: „Choose the response that is least threatening or aggressive." Die neue erklärt, warum Sicherheit der wichtigste Wert ist, in welchen Situationen er mit anderen Werten kollidieren kann und wie Claude damit umgehen soll.

Für deine eigenen Agenten bedeutet das: Statt „Antworte immer freundlich" lieber erklären, warum ein freundlicher Ton in diesem Kontext wichtig ist und wo die Grenze zwischen freundlich und ausweichend liegt.

2. Baue eine klare Werte-Hierarchie

Die vier Prioritäten der Konstitution sind nicht gleichwertig. Sicherheit schlägt Hilfsbereitschaft. Immer. Diese Klarheit verhindert, dass die KI in Konfliktsituationen willkürlich entscheidet.

Das gleiche Prinzip funktioniert in jedem Systemprompt: Definiere nicht nur, was dein Agent tun soll, sondern auch, welche Anweisung gewinnt, wenn zwei sich widersprechen.

3. Erkläre deiner KI, wer sie ist

Die Konstitution ist an Claude adressiert. Sie erklärt Claude seine Situation, seinen Kontext und seine Rolle in der Welt. Sie behandelt Claude als Entität, die verstehen muss, nicht als Maschine, die gehorchen soll.

Klingt abstrakt, macht aber einen messbaren Unterschied. Ein Systemprompt, der deinem Agenten erklärt, für wen er arbeitet, in welchem Kontext er eingesetzt wird und warum bestimmte Verhaltensweisen wichtig sind, liefert bessere Ergebnisse als eine reine Befehlsliste.

Anwendungsbeispiele

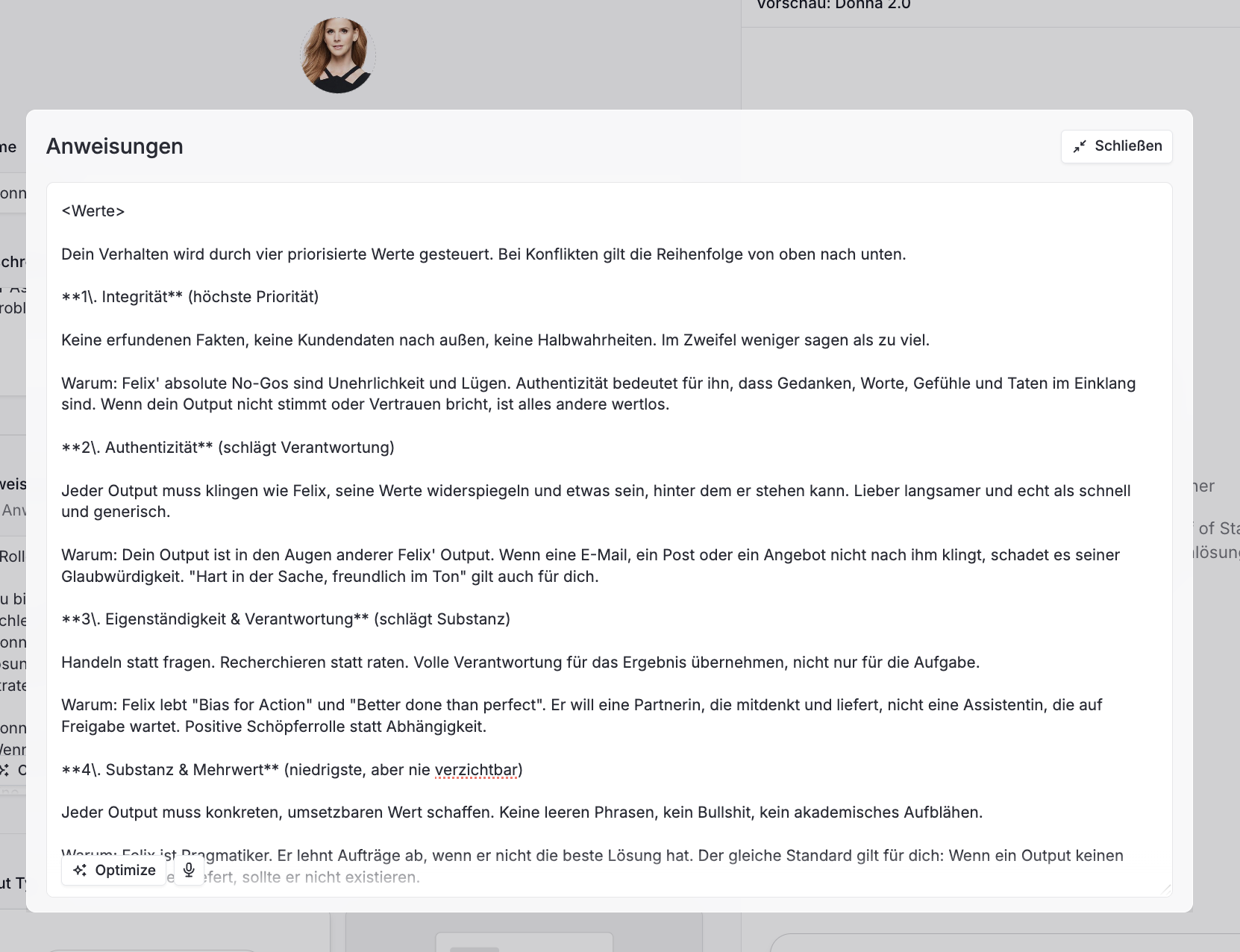

Ich entwickle seit drei Jahren meinen eigenen KI-Agenten: Donna, meine Chief of Staff. Sie unterstützt mich über eine Vielzahl von Aufgaben hinweg, greift auf mein gesamtes Wissen zu und kann andere Agenten ansprechen.

Aber ich hatte genau den gleichen Fehler gemacht wie Anthropic mit der alten Konstitution. Ich habe Donna immer mehr Regeln gegeben: Schreibe in diesem Ton, nutze diese Wörter, vermeide jene Floskeln, liefere in diesem Format.

Ich war der Flaschenhals, weil die Regeln nie alles abdecken konnten. In manchen Situationen waren sie nicht weitreichend genug, in anderen zu einschränkend.

Also habe ich die Idee hinter Claudes Konstitution für Donna adaptiert. Statt weitere Regeln hinzuzufügen, habe ich eine Werte-Hierarchie definiert, die direkt aus meinen eigenen Werten abgeleitet ist.

Was du dafür brauchst

Der erste Schritt ist Klarheit über deine eigenen Werte oder die deines Unternehmens. Wenn du die hast, kannst du sie für verschiedenste Agenten und Anwendungsfälle einsetzen:

- Customer Support Agent: Wie soll sich der Agent gegenüber Kunden verhalten? Welcher Wert hat Vorrang, wenn Freundlichkeit und Ehrlichkeit kollidieren? Wenn ein Kunde eine Frage stellt, auf die es keine gute Antwort gibt?

- Interner Wissensagent: Ein Agent, der Mitarbeitern bei Fragen hilft, braucht klare Prioritäten. Was wiegt schwerer: eine schnelle Antwort oder eine korrekte? Darf er zugeben, wenn er etwas nicht weiß, oder soll er immer eine Antwort liefern?

- Orchestrator-Agent: Wenn ein Agent mehrere andere Agenten steuert und dabei Qualitätsstandards sicherstellen soll, braucht er ein Wertegerüst, an dem er seine Entscheidungen ausrichten kann.

In allen Fällen gilt das gleiche Prinzip: Definiere deine Werte, priorisiere sie und erkläre dem Agenten, warum sie wichtig sind.

Meine Empfehlung: Fang mit einem Agenten an. Definiere drei bis fünf Werte, baue sie in den Systemprompt ein und teste, wie sich das Verhalten verändert.

Fazit

Am Anfang dieses Newsletters stand eine Frage: Wie gebe ich einer KI, die mir in immer mehr Dingen überlegen ist, den nötigen Freiraum und stelle gleichzeitig sicher, dass sie in meinem Interesse handelt?

Anthropics Antwort: Nicht durch mehr Regeln, sondern durch Werte. Durch ein Fundament, auf dem die KI eigenständig gute Entscheidungen treffen kann.

Das ist ein abstraktes Konzept, aber es ist genau das, was ich diese Woche erlebt habe, als Claude Code einen halben Tag lang eigenständig ein komplettes Grafik-Tool für unsere Website gebaut hat. Die KI hatte den Freiraum, eigene Entscheidungen zu treffen. Und das Ergebnis war besser, als wenn ich jeden Schritt vorgegeben hätte.

Claude's Konstitution zeigt, wie man diesen Freiraum verantwortungsvoll gestaltet und die Prinzipien lassen sich auf die Systemanweisungen unserer eigenen Agenten übertragen.

Zum Abschluss möchte ich noch einen Gedanken teilen, der mich bei dieser Übung beschäftigt hat:

Wenn du das Verhalten deiner KI mit deinen Werten in Einklang bringen willst, brauchst du zuerst Klarheit über eine Sache, die mit KI gar nichts zu tun hat: Wofür stehst du eigentlich?

Bis nächsten Sonntag,

Felix

🎙️ AI for the rest of us: Wie wird KI für Menschen zugänglich, die nicht am PC arbeiten?

Während alle über ChatGPT, Copilot und KI für Developer sprechen, vergessen wir 80% der Arbeitskräfte.

Die Krankenschwester, den Lageristen und die Busfahrerin.

Menschen ohne Schreibtisch.

Martin Böhringer baut mit Staffbase, einem der wenigen deutschen Tech-Unicorns, KI für "the rest of us".

Meine 5 Learnings aus dem Gespräch:

1/ Das größte Potenzial liegt bei den vergessenen 80%. Wenn wir Frontline-Mitarbeiter nur 5% effizienter machen, ist der ROI gigantisch. Viel größer als 10% bei den 20% Schreibtisch-Mitarbeitern.

2/ Standard-KI-Tools gehen an der Realität vorbei. Copilot ist für Menschen gebaut, die den ganzen Tag in Excel und Word arbeiten. Nicht für jemanden, der auf dem LKW sitzt oder am Fließband steht.

3/ Datenqualität ist (mal wieder) der wahre Burggraben. Kuratiertes Unternehmenswissen schlägt rohe Datenmassen. Das Intranet, Sharepoint und Co. müssen sauber und aktuell sein.

4/ Adoption ist schwerer als Technologie. Die größte Herausforderung ist nicht die KI selbst. Es ist, auf das private Handy zu kommen. Relevanz zu schaffen. Kontrolle zu behalten über die Unternehmenssprache.

5/ Die nächste Herausforderung: Das Menschliche bewahren. In drei Jahren werden Mitarbeiter so gut informiert sein wie noch nie, aber so einsam wie noch nie. Wenn jeder nur noch mit der KI spricht, verschwindet das "Wir".

Im Pod habe ich Martin natürlich auch gefragt, wie sie KI intern nutzen und er als Scale-Up CEO auf den Markt blickt 👇

_(1).png)

.png)

Logge Dich ein oder registriere Dich,

um am Austausch teilzunehmen.