Herzlich Willkommen zu den AI FIRST Insights!

Wir befinden uns in einer wichtigen Übergangsphase von Generativer KI - weg von synchronen Chatbots, hin zu autonomeren Systemen.

Die heutigen KI Chatbots werden uns in 12 Monaten wie Röhrenfernseher vorkommen.

In dieser Ausgabe lernst Du, wie sich ChatGPT & Co. weiterentwickeln und welche Auswirkungen das auf unsere Arbeit hat.

Los geht's!

Update AI Collective

Am 15.05. eröffnen wir das AI Collective für maximal 30 Teilnehmer, die künstliche Intelligenz innerhalb von 12 Monaten tiefgreifend in ihre Arbeit, ihr Team und die DNA ihres Unternehmens integrieren möchten. Mit unserer Akademie, Wissenshub, wöchentlichen Live-Sessions und monatlichen Experten-Deep-Dives befähigen wir dich, dein Unternehmen erfolgreich in die KI-Ära zu führen.

Update:

Seit der Ankündigung des AI Collective am 09.03. hat sich viel getan:

- Die ersten 11 Mitglieder sind fix dabei und wir haben viele weitere mündliche Zusagen erhalten. Weiterhin sind jedoch Plätze verfügbar.

- Wir haben entschieden, vorerst keine KI- und IT-Berater aufzunehmen, um uns auf Teilnehmer zu konzentrieren, die KI in ihrem eigenen Unternehmen implementieren möchten.

- 4 weitere Experten wie Sebastian Küpers (Chief Transformation Officer Plan.Net), Fabian Moritz (Microsoft MVP), Georg Neumann (Bild-KI Experte) und Victor Bellu (AI Product Manager) werden ihr Wissen in unseren Deep Dives teilen.

Du möchtest dabei sein?

- Alle Informationen findest du hier. Trage dich auf die Warteliste ein, und wir senden dir ein individuelles Angebot sowie das detaillierte Programm zu.

- Am 19.03. um 12 Uhr findet ein Online-Q&A statt, in welchem wir einen Überblick über das AI Collective geben und alle Fragen beantworten. Antworte mir auf diese E-Mail und ich schicke dir die Termineinladung.

Mehr Informationen zum AI Collective

Status Quo von Chatbots

KI-Chatbots wie ChatGPT und Copilot haben sich zu unverzichtbaren Werkzeugen für Büroarbeiter und viele andere Berufsgruppen entwickelt. Allein OpenAI verzeichnet beeindruckende 400 Millionen wöchentlich aktive Nutzer auf ChatGPT.

In den vergangenen zwei Jahren haben sich die Funktionen von Chatbots und die Fähigkeiten der zugrundeliegenden Sprachmodelle kontinuierlich weiterentwickelt:

- Die Reaktionszeit wurde deutlich verkürzt

- Die Qualität der Ergebnisse hat sich signifikant verbessert

- Die Auswertung von Dateien, Bildern und gesprochener Sprache wurde implementiert

- Die Modelle haben ihre Fähigkeiten bei logischen und komplexen Aufgaben (Reasoning) gesteigert

- Erste autonome Funktionen wie Deep Research und Computer Use/Operator wurden in die Anwendungen integriert

(Hier gelangst Du zum unserem großen KI Chatbot Vergleich inkl. Cheat Sheet)

Mit diesen Chatbots können wir heute synchron zusammenarbeiten:

- Eingabe -> Antwort -> Feedback -> x-fache Iteration

- Kommunikation via Text-Eingabe oder Audio

Die Anwendungsfälle für KI-Chatbots sind meist grundlegend:

- Texte erstellen und zusammenfassen

- Suchen im Internet ausführen

- Neue Ideen entwickeln

- ... du kennst es ja :)

Meine These für 2025: KI-Chatbots werden sich zu Plattformen entwickeln, die immer mehr menschliche Tätigkeiten beeinflussen. Dies wird ermöglicht durch die Anbindung unserer Daten, Integration in Drittsysteme, leistungsstärkere Modelle, Multimodalität und autonome Fähigkeiten.

Die 4 wichtigsten Entwicklungen beschreibe ich im weiteren Verlauf dieser Ausgabe.

1. Multimodalität

Multimodalität bezeichnet die Fähigkeit von Sprachmodellen, verschiedene Datenquellen zu verarbeiten – darunter Text, Bild, Video, Audio und Code. Während die ersten LLMs ausschließlich Text verarbeiten konnten, sind heutige Modelle deutlich flexibler und entwickeln zunehmend leistungsfähigere multimodale Fähigkeiten.

Bild

Nahezu alle gängigen LLMs können inzwischen Bilder verarbeiten und beschreiben. Die Qualität der Ergebnisse korreliert dabei direkt mit dem Umfang der Trainingsdaten (z.B. für Bilder von Hunden). Diese Fähigkeit nutze ich häufig, um Prozess-Charts erklären oder dokumentieren zu lassen.

Die rasante Qualitätssteigerung in der Bildverarbeitung zeigt sich eindrucksvoll am kürzlich veröffentlichten Google Gemini 2.0 Flash Image Generation Modell. Dieses kann nicht nur Bilder erstellen, sondern auch:

Objekte in einem Bild austauschen

Objekte eines Bildes in ein Bild einsetzen

Texte in Bilder schreiben

Die Bildverarbeitung ermöglicht es zudem, Sprachmodelle zur Computersteuerung einzusetzen. In einem Beispiel bat ich Claude 3.5 Sonnet, den Inhaber der AI FIRST Website zu ermitteln. Claude öffnete Firefox und wechselte dann systematisch zwischen Bildschirmaufnahme, Analyse des Screenshots, Beschreibung des nächsten Schritts und Ausführung der Aktion im Browser.

Im Screenshot siehst Du gut, wie Claude den Screenshot macht, beschreibt was er sieht und den nächsten Schritt ausführt. So arbeitet er sich Schritt für Schritt durch den Suchprozess.

Audio

In der KI-Ära entwickelt sich gesprochene Sprache zur Standard-Kommunikationsform mit Maschinen. Wer den Advanced Voice Mode von ChatGPT kennt, weiß, wie gut Sprachmodelle bereits in der Verarbeitung von Sprache sind und mit immer geringerer Latenz reagieren.

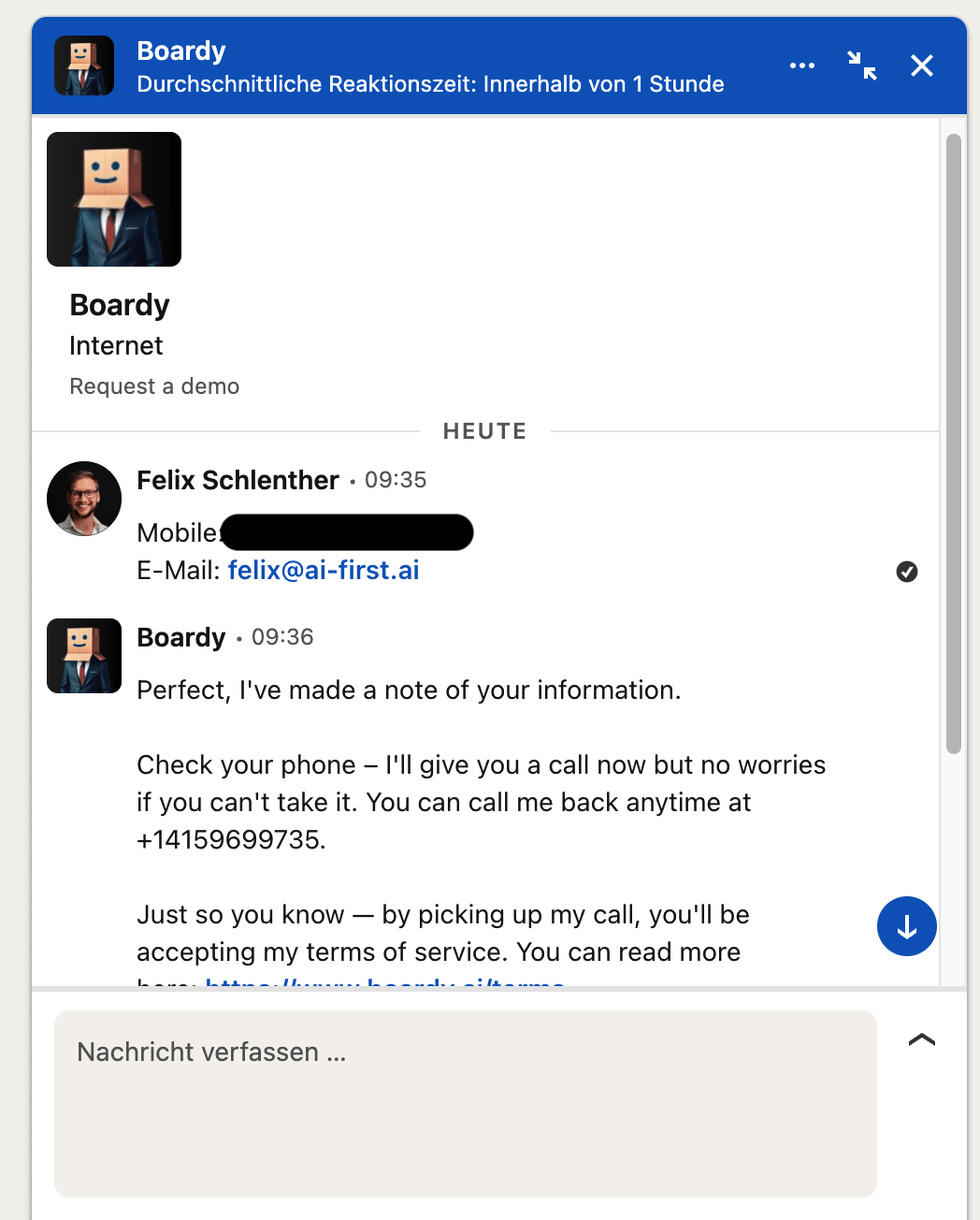

Künftig werden wir deutlich häufiger mit unseren KI-Assistenten sprechen, anstatt Aufgaben schriftlich zu formulieren. Wie natürlich diese Interaktion bereits funktioniert, kannst du selbst im Gespräch mit Boardy erleben. Schreibe dazu Boardy auf LinkedIn eine Nachricht mit deiner E-Mail und Telefonnummer.

Boardy wird dich innerhalb weniger Sekunden anrufen, um dich kennenzulernen und ein Gespräch zu führen. Die Unterhaltung verläuft natürlich, mit leichter Latenz, aber insgesamt sehr angenehm.

Auf Wunsch vermittelt Boardy basierend auf deinen Interessen, Zielen und Herausforderungen Kontakte zu anderen Personen, die dir möglicherweise weiterhelfen können.

Warum erwähne ich dieses Beispiel? Stelle dir vor, du telefonierst morgen mit deinem KI-Assistenten, erhältst Status-Updates vom Vortag, briefst neue Aufgaben und er macht sich an die Arbeit. Dies ist keine Science-Fiction mehr, sondern steht kurz vor der Realisierung.

Video

Besonders spannend wird es, wenn Sprachmodelle Videos in Echtzeit verarbeiten können.

Google hat diese Funktion bereits ansatzweise in Gemini integriert und ermöglicht die Zusammenfassung oder Beschreibung von YouTube-Videos.

Während die Zusammenfassungsfunktion derzeit noch ausbaufähig ist und die Beantwortung spezifischer Fragen zu Videos noch nicht zuverlässig funktioniert, bietet das Google AI Studio bereits einen Ausblick in die Zukunft. Dort arbeitet die Video-Zusammenfassung bereits beeindruckend gut.

Im Google AI Studio nutze ich heute schon das Echtzeit-Streaming. Bei der Arbeit an Präsentationen oder Konzepten teile ich meinen Bildschirm und kommuniziere mit Gemini. Ich erläutere mein Projekt und meine Ziele, während Gemini meinen Bildschirm sieht. So kann ich beispielsweise Vorschläge zur Strukturierung oder Visualisierung einer Folie einholen.

Gemini erkennt meine Anpassungen in Echtzeit und gibt unmittelbares Feedback.

So sieht für mich die Zukunft der Mensch-KI-Interaktion aus. Wir teilen unseren Bildschirm mit unserem KI-Assistenten, kommunizieren via gesprochener Sprache und arbeiten gemeinsam an dem Problem.

2. Modell Orchestration (& bessere LLMs)

Ein weiterer (dringend notwendiger) Schritt ist die Orchestration der angeschlossenen Sprachmodelle in KI-Chatbots.

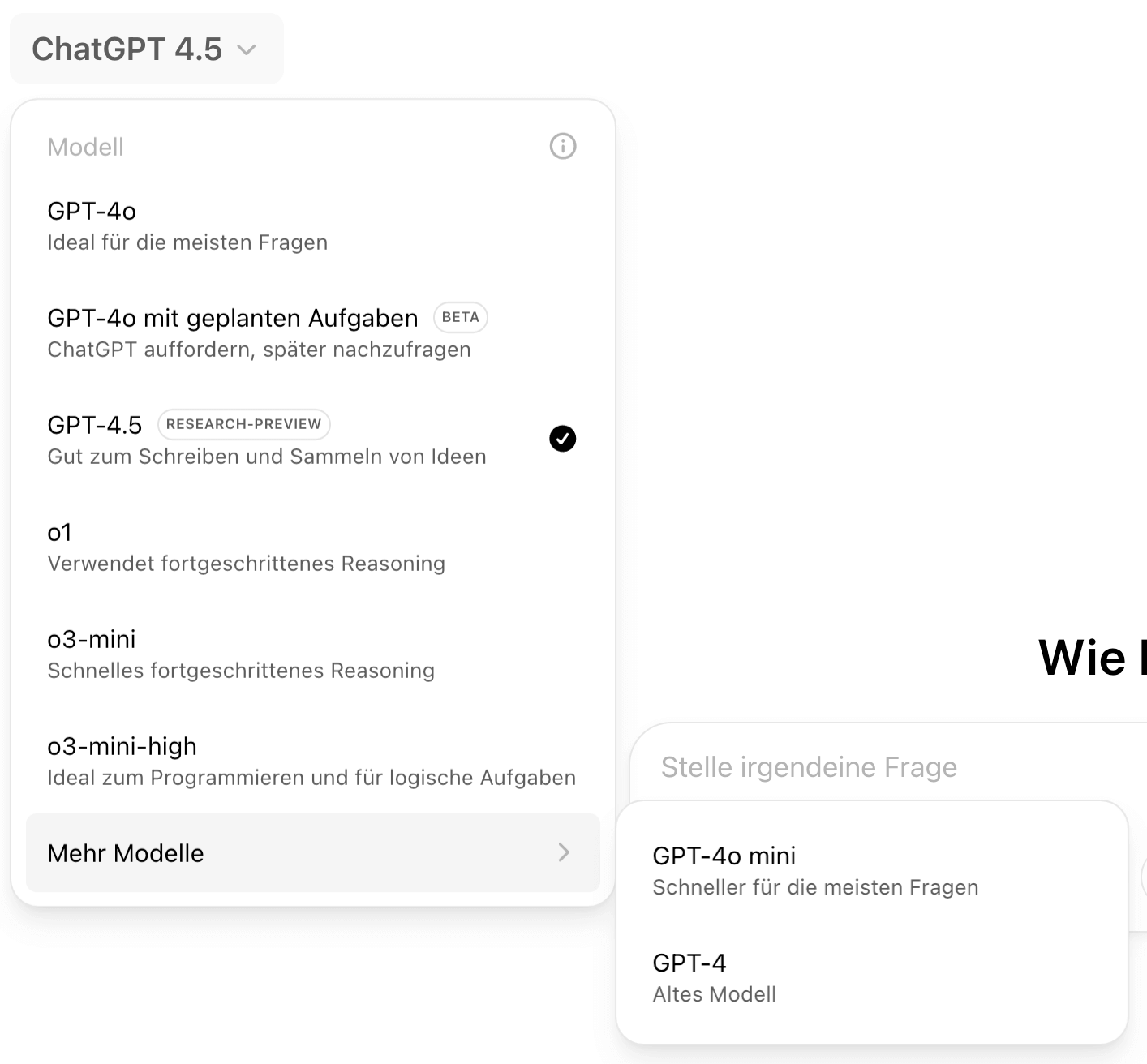

GPT-4o, o3-mini, high, mit Aufgaben, ohne Aufgaben, mit Deep Research... in den letzten 6 Monaten ist ein Sammelsurium an Modell-Varianten in den Chatbots entstanden, was kaum noch zu verstehen ist.

Dieses Chaos wird wahrscheinlich schon bald ein Ende haben.

Du wirst dir dein Modell nicht mehr selbst aussuchen, sondern der Bot übernimmt das basierend auf deiner Eingabe für dich. Reasoning und GPT Modelle werden je nach Aufgabe gewählt und kombiniert. Das steigert die Qualität der Ausgaben:

Auch diese Änderung wird zu einer besseren Nutzererfahrung und höheren Qualität der Ergebnisse führen.

3. Integrationen

Derzeit bieten die meisten Chatbots lediglich grundlegende Integrationen zu Sharepoint oder Google Drive, um einzelne Dokumente als Kontextwissen für Assistenten oder Projekte bereitzustellen. Während dies im privaten Umfeld ausreichend sein mag, erfordert der Unternehmenskontext deutlich umfassendere Schnittstellen und Datenanbindungen.

These: KI-Chatbots werden zukünftig mit zahlreicheren Integrationen ausgestattet, um größere Wissensmengen zu verarbeiten und Aktionen in Drittsystemen ausführen zu können. Erst diese erweiterten Anbindungen ermöglichen eine tiefgreifende Integration in bestehende Geschäftsprozesse.

Beispiel-Integrationen:

- Jira: Lesen und Erstellen von Tickets

- Outlook: Verarbeiten und Verfassen von E-Mails

- Confluence: Zugriff auf Richtlinien und Dokumentationserstellung

- Asana: Abrufen von Projektplänen und Anlegen neuer Aufgaben

Enterprise-AI-Plattformen und maßgeschneiderte CompanyGPTs bieten diese Anbindungen heute bereits an. Wenn OpenAI, Anthropic und vergleichbare Anbieter mehr Unternehmenskunden gewinnen möchten, müssen sie in diesem Bereich nachziehen.

Google hat mit dem Agentspace bereits ein Produkt angekündigt, das deutlich in diese Richtung weist.

KI-Plattformen werden künftig zum Standard-Technologie-Stack jedes Unternehmens gehören, um a) Unternehmenswissen durchsuchbar zu machen, b) die Produktivität der Mitarbeiter zu steigern und c) Prozesse zu automatisieren. Für eine effektive Umsetzung dieser Ziele muss die KI-Plattform – wenn man's richtig machen will – tief in die bestehende Systemlandschaft integriert werden.

4. Autonome Fähigkeiten

Ich vermute dass OpenAI in den nächsten 4-6 Wochen das Agenten-Feature in ChatGPT launchen wird. Deep Research war ein kleiner Vorgeschmack dafür.

Agenten können im Vergleich zum Chatbot:

- Ziele in Aufgaben runterbrechen

- Tools nutzen, um die Aufgabe zu erfüllen

- Ihre Aktionen anpassen, wenn sie nicht zum Erfolg führt

- Ein Gedächtnis aufbauen, um Fehler nicht zu wiederholen

Wie das in ChatGPT aussehen könnte:

Das Bild zeigt ein geleaktes Foto einer OpenAI-Präsentation. Auf dem Bildschirm sind verschiedene Workflows und die darin ausgeführten Aufgaben zu sehen.

Ein weiterer Hinweis ist der Artikel in "The Information" vom 5. März, der berichtet, dass OpenAI die Veröffentlichung von drei Agenten-Anwendungen plant:

- Sales Agent (2.000$/Monat)

- Softwareentwicklung Agent (10.000$/Monat)

- Research Agent auf Dr.-Niveau (20.000$/Monat)

Ob das genau so eintreten wird, steht in den Sternen.

All dies deutet jedoch stark auf die nächste Evolutionsstufe von Tools wie ChatGPT hin:

Systeme, die mit Zugriff auf deine Daten und Tools selbstständig Aufgaben erledigen können.

Dies ist natürlich schon längst mit Tools wie Make oder Zapier möglich, wird jedoch jetzt durch Funktionen wie Deep Research, Computer Use und Modell-Orchestration erheblich verstärkt.

🏁 Fazit

KI-Chatbots, wie wir sie heute kennen, werden bald der Vergangenheit angehören.

Wir stehen vor zwei entscheidenden Entwicklungen:

- Die multimodale Interaktionsfähigkeit über Stimme und Video mit zunehmender Echtzeit-Interaktion in unserem Arbeitsalltag. Ein KI-Assistent, der weiß, woran du gerade arbeitest, mit dem du wie mit einem Menschen kommunizieren kannst und der dich in Echtzeit bei der Lösung von Aufgaben unterstützt.

- Autonomere Fähigkeiten zur Automatisierung mehrschrittiger Aufgaben und nahtloser Integration in Arbeitsprozesse. Die Einbindung des KI-Assistenten in deine Prozesse, um im Hintergrund selbstständig Aufgaben zu erledigen.

Diese Entwicklung wird einen riesigen Einfluss auf unsere Arbeitsweise haben - mit Chancen und Risiken.

Um von dieser Entwicklung zu profitieren, sind 3 Voraussetzungen wichtig:

1. Qualitative, zugängliche Daten

2. Kompetenzen im Umgang mit GenAI

3. Strukturierte, dokumentierte Prozesse

Was ist deine These für die Weiterentwicklung von Tools wie ChatGPT?

Ich bin gespannt auf Deine Gedanken!

.webp)

Logge Dich ein oder registriere Dich,

um am Austausch teilzunehmen.